A/B testing voor beginners: de complete stap-voor-stap gids

Je wilt graag aan de slag met A/B testing, maar je weet niet waar je moet beginnen. Ik herken het. Toen ik jaren geleden mijn eerste A/B test wilde opzetten, staarde ik minutenlang naar mijn scherm. Welke pagina ga ik testen? Wat moet ik precies aanpassen? En hoe weet ik of mijn test geslaagd is?

De afgelopen 16 jaar heb ik 7.500+ A/B testen uitgevoerd als freelance CRO specialist. Ik heb deze gids geschreven om jou te helpen je eerste A/B test op te zetten en je eerste test te draaien.

A/B testing lijkt ingewikkeld, maar dat valt reuze mee. Sterker nog: als je de basis begrijpt, kun je al snel tests draaien die echt impact hebben op je conversie. In dit artikel leer je precies hoe je jouw eerste A/B test opzet én hoe je door kunt groeien naar complexere experimenten.

Voorbeeld van een A/B test. Kun je het verschil vinden?

Voorbeeld van een A/B test. Kun je het verschil vinden?

Wat is A/B testing eigenlijk?

A/B testing (ook wel split testing genoemd) is eigenlijk best simpel. Je maakt twee versies van een pagina en laat beide versies zien aan je bezoekers. De ene helft ziet versie A (de originele), de andere helft ziet versie B (de variant). A/B test software bepaalt automatisch wie welke versie ziet.

Na een tijdje kijk je welke versie het beste presteert. Meer aankopen? Meer inschrijvingen? Meer klikken? De winnaar implementeer je permanent op je website.

Het mooie is dat je niet meer hoeft te gissen wat werkt. Je laat je bezoekers bepalen wat het beste is. En dat is precies waar conversie-optimalisatie om draait: data-gedreven beslissingen nemen in plaats van op je buikgevoel varen.

Verbeter je conversie, krijg tips:

5.000+ mensen ontvangen mijn CRO tips

Max één e-mail per maand

Waarom A/B testing zo krachtig is

Ik zie het bij klanten keer op keer: kleine aanpassingen kunnen enorme impact hebben. Een andere afbeelding of video? 30% meer conversie. Een kortere tekst? 18% meer conversie. Een extra vertrouwenssignaal volgens Cialdini's principes? 25% minder bounces.

Het probleem is dat je van tevoren nooit weet wát precies gaat werken. Wat bij de ene webshop fantastisch werkt, kan bij jou juist conversie kosten. Daarom testen we.

Een voorbeeld uit mijn praktijk: ik testte voor een webshop een nieuwe headline op de homepage. Mijn klant was er heilig van overtuigd dat "Gratis verzending vanaf €50" beter zou werken dan de huidige "Morgen in huis". Na twee weken testing bleek het tegenovergestelde waar: de huidige headline won met 12% meer conversie. Zonder test hadden we perongeluk juist minder bestellingen gekregen.

Door te testen neem je geen risico. Je probeert gewoon of iets beter werkt, en als het niet werkt ga je gewoon door met de oude versie. Win-win.

Voordat je begint: de fundatie

Stop. Voordat je begint met testen, moet je fundament op orde zijn. Ik zie te vaak bedrijven die meteen willen beginnen met A/B testing, terwijl hun website fundamentele problemen heeft.

Hiermee bedoel ik de conversie-optimalisatie piramide. A/B testing zit aan de top. Maar zonder een solide basis - functionele website, duidelijke waardepropositie, vertrouwen - hebben tests weinig zin.

Check eerst of je klaar bent voor A/B testing:

- Heeft je belangrijkste pagina minstens 2.500 bezoekers per week?

- Converteren er minimaal 100 mensen per week?

- Heb je analytics correct ingesteld?

- Weet je wie je doelgroep is en wat ze willen?

Wil je experimenten uitvoeren op een platform of marktplaats, of kan je technisch niet A/B testen? Lees dan mijn geavanceerde artikel over switchback experimenten.

Heb je te weinig bezoekers voor A/B testing?

Geen paniek. Veel websites hebben simpelweg niet genoeg bezoekers voor betrouwbare A/B tests. Een test die maanden duurt is niet praktisch.

Gelukkig zijn er alternatieven. In mijn artikel over conversie-optimalisatie met weinig bezoekers behandel ik dit uitgebreid, maar hier de belangrijkste alternatieven als je (nog) niet kunt A/B testen:

1. Preference tests

Via een online panel laat je mensen kiezen tussen verschillende opties. "Welke versie spreekt je meer aan?" Dit werkt goed voor design keuzes, headlines en visuals. Je hebt veel minder traffic nodig (50 respondenten is vaak genoeg) en je krijgt ook kwalitatieve feedback.

Het nadeel? Je meet voorkeur, niet daadwerkelijk gedrag. Mensen zeggen soms iets anders dan wat ze doen. Maar voor eerste inzichten is het perfect.

Meer weten? Lees dan mijn artikel over preference testing.

2. Fake-door tests

Hier test je nieuwe features of producten voordat je ze écht bouwt. Je plaatst bijvoorbeeld een button voor een nieuwe dienst die nog niet bestaat. Als mensen erop klikken, krijgen ze een bericht: "Deze feature komt binnenkort! Laat je email achter om op de hoogte te blijven."

Zo test je behoefte zonder development. Als 30% van je bezoekers klikt: groen licht. Als niemand interesse heeft: geld en tijd bespaard.

Meer weten? Lees dan mijn artikel over fake door testing.

3. Focus op kwalitatief onderzoek

Analyseer je heatmaps, doe user testing, en los de meest voor de hand liggende problemen eerst op. Bij weinig traffic kun je vaak meer winst halen uit het oplossen van duidelijke frustraties dan uit A/B testing.

5.000+ mensen gingen je voor. Ontvang gratis tips en boost je conversie.

5.000+ mensen ontvangen mijn CRO tips

Max één e-mail per maand

Stap 1: Kies wat je gaat testen

Begin klein. Ga niet meteen je hele website ombouwen. Kies één element dat je wilt verbeteren.

Belangrijk: ga niet random ideeën testen. Onderzoek eerst waar je knelpunten zitten, en test de oplossingen hiervoor.

Makkelijke eerste tests (perfect voor beginners):

- Je headline op je landingspagina (tips hier)

- Je productfoto's (product vs lifestyle foto)

- De volgorde je voordelen in je checkout

Complexere tests (als je meer ervaring hebt):

- Korte vs uitgebreide productbeschrijvingen

- Het weglaten van een heel formulierveld in je checkout

- Verschillende psychologische prijstechnieken (€99,99 vs €100 vs "Normaal €149, nu €99")

- Het toevoegen van urgentie-elementen ("Nog 3 op voorraad")

Let op het verschil: bij makkelijke tests verander je één klein element. Bij complexere tests pas je iets aan dat meer impact heeft op de user experience en waar meerdere psychologische principes bij komen kijken.

Ik raad aan om te beginnen met een pagina die al redelijk veel bezoekers heeft én hoog in je conversie funnel zit. Waarom? Omdat je dan sneller resultaat ziet én meer mensen bereikt met je verbetering.

Prioritering: welke test doe je eerst?

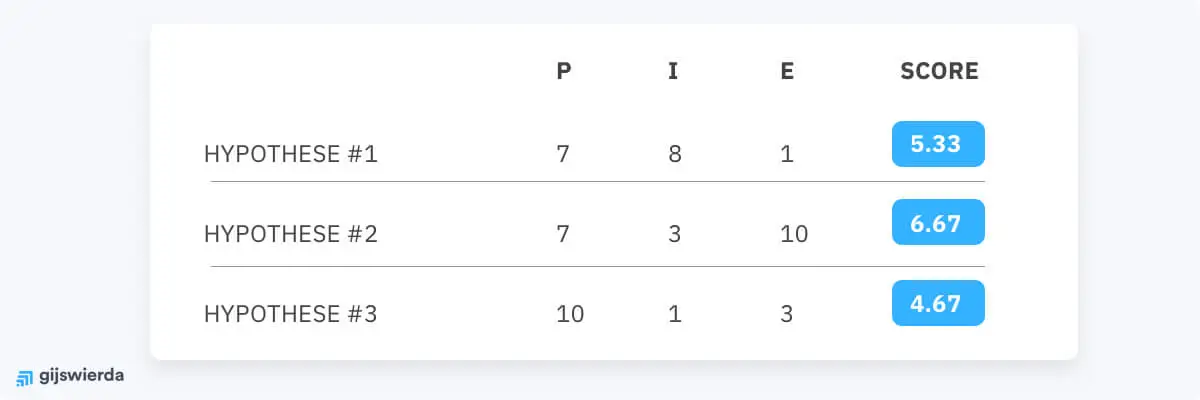

Gebruik het PIE-framework om te bepalen welke test je eerst doet:

- Potential: Hoeveel verbetering is mogelijk? (1-10)

- Importance: Hoe belangrijk is deze pagina? (1-10)

- Ease: Hoe makkelijk is de test op te zetten? (1-10)

Tel de scores bij elkaar op. De hoogste score is je volgende test.

Voorbeeld van ingevuld PIE model

Voorbeeld van ingevuld PIE model

Bijvoorbeeld: je checkout heeft veel potential (8), is super belangrijk (10), en een button kleur testen is makkelijk (9). Score: 27. Je 'over ons' pagina heeft weinig potential (3), is niet zo belangrijk (4), maar ook makkelijk te testen (8). Score: 15. Keuze is duidelijk.

Stap 2: Formuleer je hypothese (het wetenschappelijke fundament)

Een hypothese klinkt misschien wetenschappelijk, maar het is gewoon een voorspelling. Je zegt: "Als ik dit verander, dan gebeurt dat, omdat..."

Voorbeeld van een simpele, goede hypothese:

"Als ik de call-to-action button van blauw naar oranje verander, dan krijg ik meer klikken omdat oranje beter opvalt tussen de blauwe elementen op mijn pagina."

Voorbeeld van een complexere hypothese:

"Als ik op mijn productpagina de volledige specificaties boven de fold plaats in plaats van onder een 'lees meer' link, dan krijg ik meer 'in winkelwagen' klikken omdat bezoekers nu niet meer hoeven te scrollen om de belangrijkste productinformatie te vinden. Dit vermindert cognitieve belasting en onzekerheid, wat volgens het principe van zekerheid cruciaal is voor conversie."

Zie je het verschil? Bij de tweede hypothese leg je niet alleen uit wát je doet en wát je verwacht, maar ook waaróm dit zou moeten werken op psychologisch niveau.

Een slechte hypothese is: "Ik ga de button veranderen en kijken wat er gebeurt." Dan leer je namelijk niets als de test mislukt.

Waarom is een hypothese zo belangrijk?

Zonder hypothese weet je niet waarom een test wint of verliest. En dat is waar het échte leren gebeurt. Stel: je test een langere productbeschrijving en die wint. Was het omdat mensen meer informatie wilden? Of omdat de extra lengte meer vertrouwen gaf? Of omdat de pagina er professioneler uitzag? Zonder hypothese weet je het niet.

Stap 3: Maak je variant (versie B)

Nu ga je aan de slag met het maken van je nieuwe versie. Gebruik hiervoor een A/B test tool zoals VWO, Optimizely, Convert of AB Tasty. (Google Optimize is helaas gestopt).

Belangrijke regel voor beginners: verander maar één ding tegelijk in je eerste tests. Als je meerdere dingen tegelijk aanpast, weet je niet welke aanpassing het verschil heeft gemaakt.

Ik maakte deze fout zelf ook in het begin. Ik testte een nieuwe headline én een nieuwe button kleur én een kortere tekst. De test won met 23%, maar ik had geen idee welk element de winst had opgeleverd. Had ik de button kleur kunnen behouden en toch 20% winst gepakt? Geen idee. Zonde.

Voor gevorderden: Multivariate testing

Als je meer ervaring hebt en veel traffic hebt (denk aan 10.000+ bezoekers per week), kun je multivariate testing overwegen. Hierbij test je meerdere elementen tegelijk in alle mogelijke combinaties.

Bijvoorbeeld: je test 2 headlines × 2 button kleuren × 2 productvideo's = 8 varianten tegelijk. De tool berekent dan welke combinatie het beste werkt.

Waarschuwing: dit vereist exponentieel meer traffic. Voor 8 varianten heb je 8× zoveel bezoekers nodig om significante resultaten te krijgen. Begin hier dus pas aan als je de basis beheerst.

Stap 4: Bepaal je doelstellingen (primair én secundair)

Wat wil je precies meten? Dit noemen we de conversie-doelstelling of primary metric.

Voorbeelden van primaire conversie-doelstellingen:

- Aantal voltooide aankopen (e-commerce)

- Aantal inschrijvingen voor je nieuwsbrief

- Klikken op de 'In winkelwagen' knop (micro-conversie)

- Aantal aanvragen voor een offerte (B2B)

- Downloads van een whitepaper (leadgeneratie)

Kies één hoofddoelstelling. Dit is cruciaal. Ik zie te vaak mensen die vijf KPI's willen verbeteren tegelijk. Dat werkt niet. Kies er één.

Maar let ook op secundaire metrics

Hier wordt het interessant. Een test kan je primaire doel verbeteren, maar andere metrics verslechteren. Dat noemen we een trade-off.

Voorbeeld uit mijn praktijk:

Ik testte voor een webshop "Gratis verzending" prominent in de header. Het aantal 'in winkelwagen' clicks steeg met 15% (yeah!). Maar de gemiddelde orderwaarde daalde met 12% (ouch). Waarom? Omdat de gratis verzending pas gold vanaf €50, maar mensen die normaal €80 besteedden nu precies op €51 uitkwamen.

Netto-effect? Minder omzet, ondanks meer conversie. Deze test had verloren zonder naar secundaire metrics te kijken.

Belangrijke secundaire metrics om te monitoren:

- Gemiddelde orderwaarde (AOV)

- Revenue per visitor (RPV)

- Bounce rate

- Tijd op pagina

- Scroll depth

- Uitstap percentage

In je CRO KPI dashboard kan je dit allemaal bijhouden.

Stap 5: Wanneer is een test klaar? Bayesiaanse statistiek

Je test draait al een poosje, je ziet verschillen. Mooi! Maar wanneer stop je de test? Dat is de vraag. Je wilt namelijk niet dat het verschil dat je ziet, gewoonweg toevallig is. Je wilt het zeker weten. Hier help A/B test statistiek je mee.

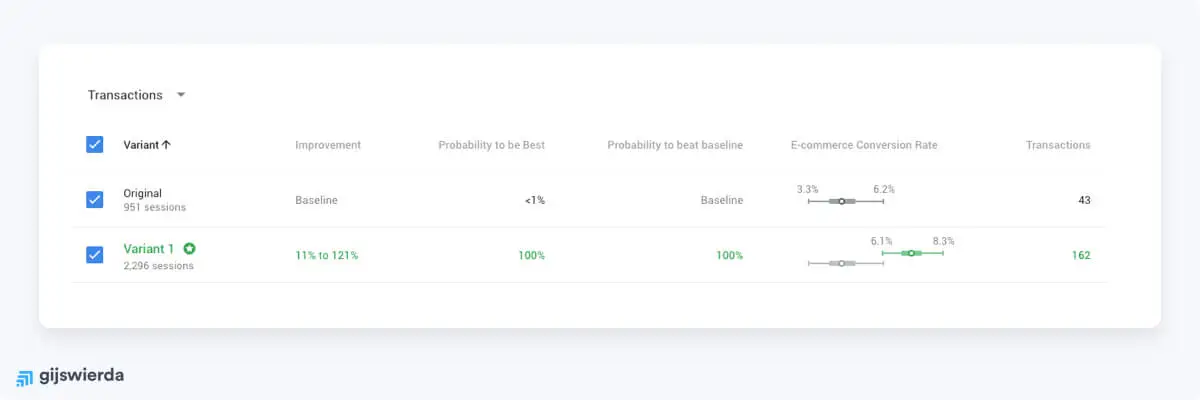

Voorbeeld van afgeronde A/B test

Voorbeeld van afgeronde A/B test

De meeste mensen leren A/B testing met frequentist statistiek (p-waardes, 95% zekerheid, etc.). Maar ik raad een andere aanpak aan: Bayesiaanse statistiek.

Waarom? Omdat Bayesiaanse statistiek veel intuïtiever is en beter aansluit bij hoe we als mensen denken. In plaats van te vragen "is dit verschil statistisch significant?", vraag je: "hoe waarschijnlijk is het dat variant B beter is dan A?"

Het verschil tussen frequentist en Bayesiaans

De traditionele (frequentist) aanpak werkt met p-waardes en vaste regels. Je mag niet tussentijds kijken, je moet van tevoren je steekproefgrootte bepalen, en je krijgt rare uitspraken zoals "p=0.03" die niet iedereen echt begrijpt.

De Bayesiaanse aanpak is anders. Je krijgt een concrete kans: "Er is 94% kans dat variant B beter is dan A." Dat is veel makkelijker te begrijpen én te communiceren naar je team of opdrachtgever.

In mijn artikel over A/B test statistiek leg ik het volledige verschil uit. Hier de korte versie:

Frequentist zegt: "Als er geen echt verschil is tussen A en B, is de kans dat we deze data zien 3%. Dus verwerpen we de nulhypothese."

Bayesiaans zegt: "Op basis van de data die we hebben gezien, is er 97% kans dat B beter is dan A."

Zie je het verschil? De Bayesiaanse uitspraak is precies wat je wilt weten!

Hoe werkt Bayesiaanse A/B testing in de praktijk?

In plaats van een vast aantal bezoekers te verzamelen en dan pas te kijken, kun je bij Bayesiaanse statistiek wél tussentijds naar je resultaten kijken.

Dat betekent niet dat je na één dag al moet stoppen als je variant voorstaat. Maar het betekent wel dat je flexibeler kunt zijn met je test-duur. Als de data na twee weken overduidelijk is (bijvoorbeeld 99% kans dat B beter is), hoef je niet langer te wachten.

Wat heb je nodig?

Ik heb een Bayesiaanse calculator gemaakt die je kunt gebruiken. Je vult in:

- Aantal bezoekers variant A

- Aantal conversies variant A

- Aantal bezoekers variant B

- Aantal conversies variant B

De calculator geeft je dan:

- De kans dat B beter is dan A (bijvoorbeeld 94%)

- Het verwachte verschil in conversie

- Een visuele weergave van de waarschijnlijkheidsverdeling

Wanneer stop je een Bayesiaanse test?

Hier is mijn praktische advies:

Minimum test-duur: 1 week

Ook met Bayesiaanse statistiek moet je minstens één volledige week testen. Waarom? Omdat mensen in het weekend anders gedragen dan doordeweeks. Je wilt een representatieve dataset.

Minimum conversies: 100 per variant

Met minder dan 100 conversies per variant zijn je resultaten niet betrouwbaar genoeg, ongeacht welke statistische methode je gebruikt.

Drempelwaarde: 90% PTBB (Probability to be Best)

Ik stop een test als:

- De kans dat B beter is >90% is (B is waarschijnlijk de winnaar)

- De kans dat B beter is <10% is (A blijft gewoon staan)

- Na 4 weken de kans tussen 10-90% blijft (geen duidelijke winnaar)

Voordelen van Bayesiaanse statistiek

Waarom vind ik Bayesiaans beter?

1. Intuïtievere resultaten

"97% kans dat B beter is" begrijpt iedereen. "p=0.03 dus we verwerpen H0" begrijpt bijna niemand.

2. Tussentijds kijken mag

Je hoeft niet te wachten op een vooraf bepaalde steekproefgrootte. Als de data overduidelijk is, kun je eerder stoppen.

3. Realistische onzekerheid

Bayesiaans vertelt je niet alleen óf B beter is, maar ook hoeveel beter. En met welke onzekerheid.

4. Kleine verschillen herkennen

Bij frequentist statistiek met weinig data krijg je vaak "geen significant verschil". Bij Bayesiaans zie je: "68% kans dat B beter is, maar het verschil is klein." Dat is veel informatieve.

Voor beginners: begin gewoon

Vind je dit allemaal nog te complex? Geen probleem. De meeste A/B test tools hebben ingebouwde statistiek. Je hoeft niet alles te begrijpen om te beginnen met testen.

Maar als je je testresultaten wilt begrijpen en betere beslissingen wilt nemen, is basis kennis van statistiek onmisbaar. Begin met mijn calculator en kijk hoe de kansen veranderen naarmate je test loopt.

Gratis CRO-tips in je inbox. Meld je aan!

5.000+ mensen ontvangen mijn CRO tips

Max één e-mail per maand

Stap 6: Laat je test lopen (met de juiste verwachtingen)

Nu komt het moeilijkste deel: geduld hebben. Ook met Bayesiaanse statistiek moet je test lang genoeg lopen.

De drie regels voor test-duur:

Regel 1: Minimaal één volledige week

Waarom? Omdat mensen in het weekend anders kopen dan doordeweeks. Maandag is anders dan vrijdag. Test altijd door een volledige week heen.

Regel 2: Minimaal 100 conversies per variant

Met minder conversies is je data te grillig. Ook al toont de Bayesiaanse calculator 90% zekerheid na 3 dagen - wacht op meer data.

Regel 3: Maximaal vier weken

Tests die langer dan vier weken lopen, hebben andere problemen. Seizoensinvloeden, externe factoren (marketing campagnes), en test fatigue kunnen je resultaten verstoren. Stop na vier weken en evalueer.

Tussentijds monitoren (mag wél bij Bayesiaans!)

Een groot voordeel van Bayesiaanse statistiek: je mag tussentijds kijken zonder je resultaten te beïnvloeden. Dit heet "continuous monitoring".

Check bijvoorbeeld elke paar dagen:

- Loopt de test technisch goed? (geen errors, goede traffic verdeling)

- Hoe ontwikkelt de waarschijnlijkheid zich?

- Zijn er al genoeg conversies?

Maar let op: kijk zonder te handelen. Alleen omdat je na 3 dagen 85% kans ziet, stop je niet. Wacht op je minimum duur en minimum conversies.

Wanneer stop je eerder?

Er zijn twee scenario's waarin je eerder mag stoppen:

1. Overduidelijke winnaar

Als na één week je >90% kans hebt én >100 conversies per variant én het verschil is groot (>10% lift), dan kun je stoppen. De data is duidelijk genoeg.

2. Technische problemen

Als je test niet goed loopt (fouten, verkeerde tracking, etc.), stop dan meteen en los het op. Slechte data leidt tot slechte beslissingen.

Stap 7: Analyseer je resultaten

Je test is afgelopen. Nu komt het leuke deel: wat zeggen de resultaten?

Drie mogelijke uitkomsten:

1. Variant B wint (>90% kans)

Gefeliciteerd! Maar stop even voordat je implementeert. Check:

- Zijn secundaire metrics ook goed? (AOV, bounce rate, etc.)

- Is het verschil groot genoeg om business impact te hebben?

- Snap je waarom deze variant won?

- Heb je minimaal 1 week getest en 100+ conversies per variant?

Als alles groen is: implementeer en vier je succes!

2. Variant A wint (<10% kans dat B beter is)

Ook goed nieuws. Je weet nu dat je originele versie beter is. Je hebt een slechte aanpassing voorkomen én je hebt geleerd.

Vraag jezelf af: waarom won de originele? Was je hypothese verkeerd? Mis je iets over je doelgroep?

3. Geen duidelijke winnaar (tussen 10-90%)

Dit gebeurt in 50-60% van alle tests. Geen probleem. Dit betekent dat het verschil te klein is of dat je te weinig data hebt.

Mogelijke vervolgstappen:

- Accepteer dat deze aanpassing geen impact heeft (behoud origineel)

- Test een grotere verandering van hetzelfde principe

- Test iets compleet anders

Dieper graven: segmentatie

Hier wordt het interessant. Soms win je totaal niet, maar wél voor specifieke segmenten.

Voorbeeld: je test toont 50% kans dat B beter is (geen winnaar). Maar als je segmenteert:

- Mobiele bezoekers: 96% kans dat B beter is (+12% conversie)

- Desktop bezoekers: 8% kans dat B beter is (-8% conversie)

Conclusie: mobiele users willen iets anders dan desktop users. Implementeer de variant alleen voor mobiel.

Check segmenten zoals:

- Apparaattype (mobiel vs desktop)

- Traffic bron (organisch vs advertenties vs direct)

- Nieuwe vs terugkerende bezoekers

- Geografische locatie

- Browser type

Gebruik hiervoor je analytics tool zoals Google Analytics gekoppeld aan je A/B test tool.

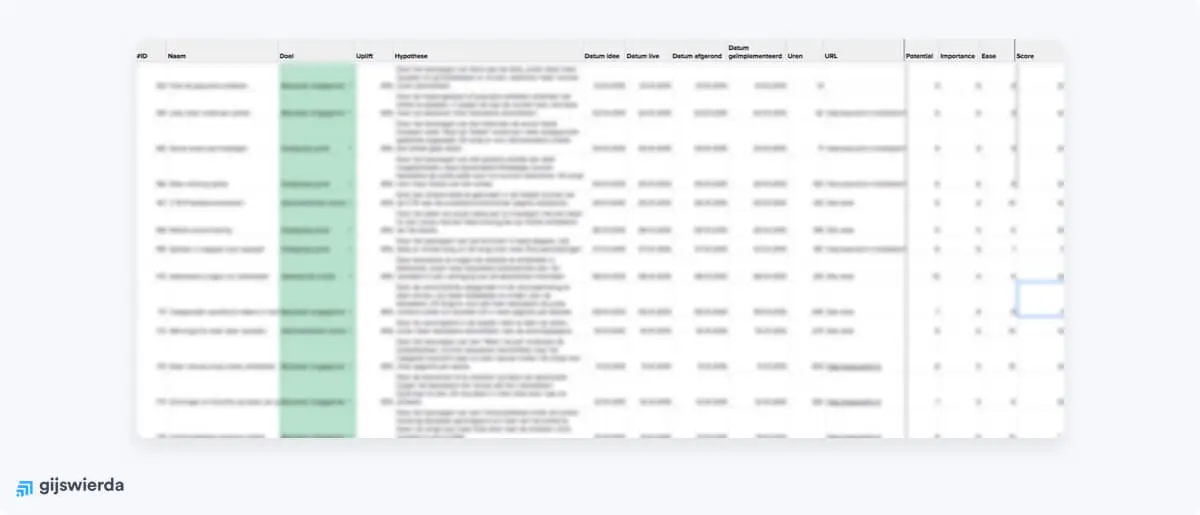

Stap 8: Documenteer en bouw aan je test cultuur

Dit is misschien wel de belangrijkste stap, maar ook de meest vergeten. Documenteer je test.

Voorbeeld van een conversie-optimalisatie backlog die ik gebruik in Google Sheets.

Wat documenteer je minimaal:

- Wat je hebt getest (screenshots!)

- Je hypothese

- Start- en einddatum

- Aantal bezoekers en conversies per variant

- Resultaten (waarschijnlijkheid, verwacht verschil, secundaire metrics)

- Winnaar + waarom je denkt dat het won/verloor

- Vervolgstappen

Ik gebruik hiervoor een simpele Google Sheet. Na een jaar heb je een schat aan informatie over wat wel en niet werkt voor jouw specifieke website en doelgroep.

De waarde van verliezers

Je verliezende tests zijn net zo waardevol als je winnaars. Ze vertellen je:

- Wat je doelgroep níet wil

- Welke aannames fout waren

- Waar je geen tijd meer aan moet besteden

Voorbeeld: ik testte drie keer verschillende vormen van urgentie ("Nog 3 op voorraad!", "Bestel binnen 2 uur", etc.) voor een webshop. Alle drie verloren of waren neutraal. Conclusie: urgentie werkt niet voor deze doelgroep. Nu weet ik dat en bespaar ik tijd.

Dit is wat ik bedoel met de 10.000-experimenten-regel. Je wordt beter door volume én door te leren van elk experiment.

Veelgemaakte fouten bij A/B testing (en hoe je ze vermijdt)

Laat ik eerlijk zijn: ik heb ze allemaal gemaakt. Zodat jij ze kunt vermijden, deel ik de meest voorkomende valkuilen.

Fout 1: Te snel stoppen

Ook met Bayesiaanse statistiek moet je geduld hebben. Test minimaal één volledige week en verzamel minimaal 100 conversies per variant. Een hoge waarschijnlijkheid na 2 dagen is niet betrouwbaar.

Fout 2: Meerdere dingen tegelijk testen (bij lage traffic)

Als je vijf elementen tegelijk aanpast, weet je niet welk element het verschil maakt. Test één ding per keer, tenzij je genoeg traffic hebt voor multivariate testing (10.000+ bezoekers per week).

Fout 3: Drempelwaarde negeren

"De variant heeft 85% kans om beter te zijn, dat is goed genoeg!" Nee. Gebruik minimaal 95% als drempel. Bij 85% is er nog 15% kans dat je de verkeerde keuze maakt.

Fout 4: Secundaire metrics negeren

Je primaire metric verbetert, maar je bounce rate schiet omhoog en je orderwaarde daalt. Dit is een verliezende test, ook al lijkt het een winnaar.

Fout 5: Externe factoren negeren

Je draait een test tijdens Black Friday. Of tijdens een grote PR-campagne. Of net na een prijsaanpassing. Al deze factoren vertekenen je resultaten. Test bij voorkeur in "normale" periodes.

Fout 6: Testen zonder hypothese

"Ik ga maar wat proberen" leidt niet tot leren. Je weet niet waarom iets werkt of niet werkt. Formuleer altijd een hypothese vooraf.

Fout 7: Te weinig traffic

Een test op een pagina met 50 bezoekers per week duurt maanden. Overweeg dan alternatieven zoals preference tests of fake-door tests (zie de weinig bezoekers gids).

Fout 8: Tests stoppen bij eerste verlies

Je eerste drie tests verliezen allemaal. Je concludeert: "A/B testing werkt niet voor ons." Stop! Testing is een marathon, geen sprint. Soms moet je 10-15 tests draaien voordat je je eerste grote winnaar vindt.

Fout 9: Alleen button kleuren testen

Button kleur tests zijn leuk om mee te beginnen, maar ze hebben meestal weinig impact. Als je echt grote winst wilt boeken, test fundamentelere dingen: je waardepropositie, je checkout flow, je productpagina structuur.

Fout 10: Tests niet implementeren

Je draait een test, hij wint, je documenteert het... en dan gebeurt er niets. De dev-afdeling heeft het te druk. De winnaar wordt nooit live. Dit is zonde. Maak implementeren onderdeel van je test-proces.

Welke A/B test tool moet je gebruiken?

Voor je eerste tests zijn er genoeg goede opties. Hier mijn aanbevelingen voor 2025:

Convert – Mijn persoonlijke favoriet voor middelgrote bedrijven. Goede prijs-kwaliteit verhouding (vanaf $299/maand). Aanrader als privacy belangrijk is. Ondersteunt zowel frequentist als Bayesiaanse statistiek.

VWO – Gebruiksvriendelijk, goede visual editor, betaalbaar (gratis tot 50k users, daarna vanaf $449/maand), en ze hebben ook heatmaps en session recordings ingebouwd. Ondersteunt Bayesiaanse statistiek.

Varify.io – Mijn persoonlijke favoriet voor kleine bedrijven. Goede visual editor, onbeperkt bezoekers, vaste prijs (€119/maand). Gemaakt in Duitsland

AB Tasty – Franse tool, goede visual editor, veel integraties. Middenmotor qua prijs en functionaliteit.

Optimizely (Web Experimentation) – De Mercedes onder de test-tools. Veel functionaliteit, zeer stabiel, maar prijzig (minimaal $60k per jaar). Geschikt voor grote enterprise bedrijven. Heeft Stats Engine (hun Bayesiaanse implementatie).

Zie ook mijn overzicht van de beste conversie-optimalisatie tools voor een complete vergelijking.

Jouw eerste test: concrete actie

Als je nog nooit een A/B test hebt gedraaid, begin dan hier:

Simpele starter-test:

Test je belangrijkste call-to-action button tekst op je meest bezochte pagina. Verander alleen de tekst. Bijvoorbeeld:

- A: "Koop nu"

- B: "Bestellen"

Of voor B2B:

- A: "Meer informatie"

- B: "Bekijk demo"

Dit is een simpele test die je in 30 minuten kunt opzetten en waar je binnen 1-2 weken resultaat van ziet. Perfect om ervaring op te doen.

Na je eerste test:

Kijk welk element op dezelfde pagina je nog kunt verbeteren. Bouw voort op je eerste test. Als je button tekst test won, test dan nu je headline. Als die won, test dan je hero image. Etcetera.

Voor meer inspiratie over wat je kunt testen, bekijk ook mijn artikelen over landingspagina's optimaliseren en website redesign aanpakken.

Word beter in CRO. Ontvang gratis tips.

5.000+ mensen ontvangen mijn CRO tips

Max één e-mail per maand

Samenvatting: jouw A/B testing checklist

Laat ik het nog even voor je samenvatten:

Voorbereiding:

- ✓ Zorg voor voldoende traffic (minimaal 1.000 bezoekers/week)

- ✓ Check of je fundament op orde is (zie de conversie-optimalisatie piramide)

- ✓ Kies een goede A/B test tool (bij voorkeur met Bayesiaanse statistiek)

- ✓ Stel je analytics correct in

- ✓ Heb je te weinig traffic? Overweeg preference tests of fake-door tests

Test opzetten:

- ✓ Kies één element om te testen (gebruik PIE-framework)

- ✓ Formuleer een sterke hypothese (wat, waarom, verwachting)

- ✓ Maak je variant (verander één ding per test)

- ✓ Bepaal primaire en secundaire metrics

- ✓ Stel je drempelwaarde in (minimaal 95% waarschijnlijkheid)

Test uitvoeren:

- ✓ Laat je test minimaal 1 volle week lopen

- ✓ Verzamel minimaal 100 conversies per variant

- ✓ Monitor tussentijds (mag bij Bayesiaans!), maar wacht op minimums

- ✓ Check op technische problemen

Resultaten analyseren:

- ✓ Check waarschijnlijkheid (gebruik Bayesiaanse calculator)

- ✓ Analyseer secundaire metrics

- ✓ Doe segmentatie analyse

- ✓ Begrijp waarom de variant won of verloor

- ✓ Kijk naar de grootte van het effect (niet alleen of het significant is)

Na de test:

- ✓ Documenteer alles (hypothese, resultaten, learnings)

- ✓ Implementeer de winnaar

- ✓ Deel je learnings met het team

- ✓ Plan je volgende test

A/B testing is geen rocket science. Het vraagt vooral geduld, discipline en nieuwsgierigheid. Begin klein, leer van elke test, en bouw je kennis langzaam op.

Vergeet niet: zelfs ervaren CRO experts hebben maar 20-30% winnende tests. Het gaat niet om elk experiment te winnen, maar om consequent te blijven testen en te leren. Zie ook de voordelen van conversie-optimalisatie voor meer over waarom deze aanpak zo waardevol is.

Klaar om te beginnen? Pak nu een kladblok en schrijf op:

- Welke pagina ga je testen? (hoogste traffic + belangrijk)

- Welk element ga je aanpassen? (één ding)

- Wat is je hypothese? (als ik X verander, dan Y omdat Z)

Dat is je startpunt. Over een paar weken heb je je eerste A/B test succesvol afgerond. En gebruik mijn Bayesiaanse calculator om je resultaten te interpreteren.

Veel succes!

Wil je meer leren over conversie-optimalisatie?

Start met de basis in mijn artikel Wat is conversie-optimalisatie, of duik direct in specifieke onderwerpen:

- A/B test statistiek uitgelegd - frequentist vs Bayesiaans in detail

- Bayesiaanse calculator - interpreteer je test resultaten

- CRO met weinig bezoekers - alternatieven voor A/B testing

- Checkout optimalisatie checklist - 45 concrete tips voor je checkout

- Headlines schrijven - wat ga je testen in je A/B test?

- De conversie-optimalisatie piramide - zorg dat je fundament op orde is

- Beste conversie-optimalisatie tools - vergelijk alle A/B test tools

- 25 beste CRO boeken - verdiep je kennis verder

Hulp nodig? Ik help CRO teams als coach of specialist met 'de voeten in de klei'

Gijs heeft meer dan 16 jaar ervaring in het verhogen van conversies als freelance CRO specialist.

Hij combineert zijn expertise in psychologie, statistiek, development, UX design en projectmanagement om alles uit CRO te halen.

Met een track record van meer dan 7.500 uitgevoerde A/B tests is hij een van Nederlands meest ervaren conversie specialisten.

Sinds 2013 is Gijs CXL Certified, een internationaal erkend certificaat voor conversie-optimalisatie.

Gijs is winnaar van de WhichTestWon Award, een internationaal erkend onderscheiding voor conversie-optimalisatie.

Dit is wat zijn klanten over hem zeggen, en dit is het verhaal van Gijs.